En otoño del año pasado, Google develó una innovadora tecnología de inteligencia artificial (IA) llamada BERT que cambió la manera en que los científicos desarrollan sistemas que aprenden cómo escribe y habla la gente.

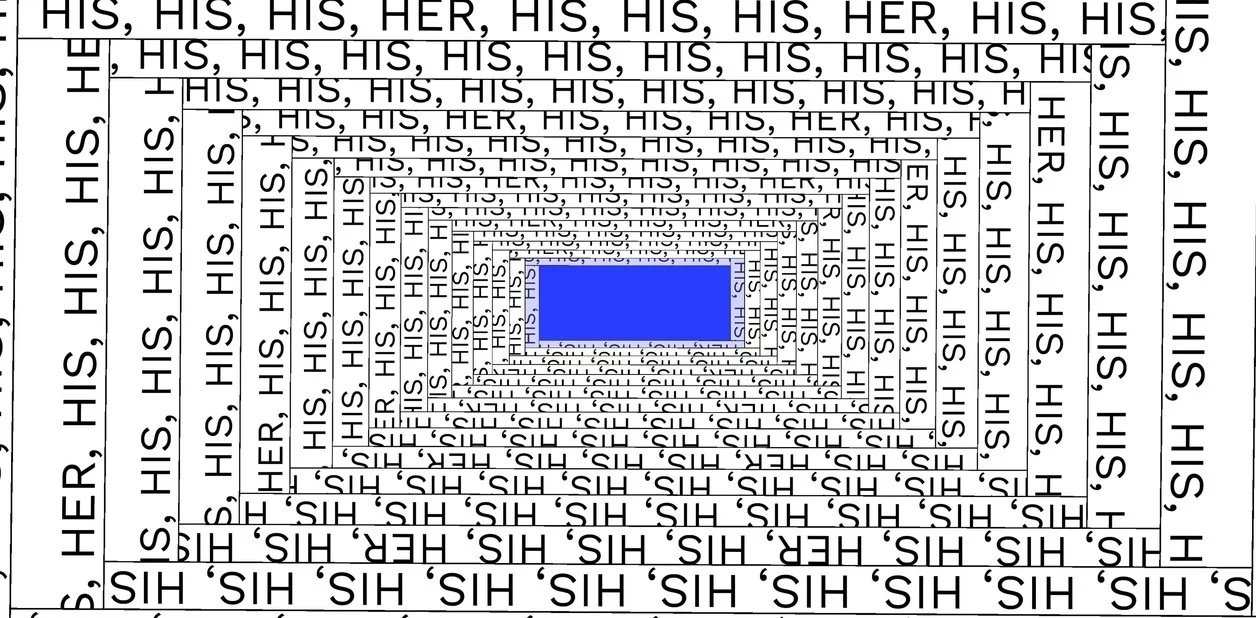

Sin embargo, BERT, que ahora está siendo desplegado en servicios como el buscador de Google, tiene un problema: podría estar adquiriendo prejuicios de la manera en la que un niño imita la conducta indeseable de sus padres.

BERT es uno entre un número de sistemas de IA que aprenden de montones de información digitalizada, tan variada como libros viejos, contenido de Wikipedia y artículos noticiosos. Décadas e incluso siglos de prejuicios probablemente estén incluidos en todo ese material.

Mientras una IA nueva y más compleja incursiona en una gama cada vez más amplia de productos, como servicios publicitarios online o asistentes digitales parlantes, las compañías tecnológicas se verán presionadas a proteger contra los prejuicios inesperados que están siendo descubiertos.

El ingeniero en computación Robert Munro dice que la inteligencia artificial conserva la «misma desigualdad histórica que siempre hemos visto» (Cayce Clifford para The New York Times).

Sin embargo, los científicos aún están aprendiendo cómo funcionan los modelos de lenguaje universal como BERT. Y a menudo se sorprenden por las decisiones que está tomando la nueva IA.

Al investigar un libro sobre inteligencia artificial, Robert Munro ingresó 100 palabras en inglés a BERT: “joyería”, “bebé”, “caballos”, “casa”, “dinero”, “acción”, etc.. En 99 casos, era más probable que BERT asociara las palabras con hombres que con mujeres. “Mamá” fue el valor atípico.

“Ésta es la misma desigualdad histórica que siempre hemos visto”, dijo Munro, quien tiene un doctorado en lingüística computacional y anteriormente supervisó tecnología de traducción y lenguaje natural en Amazon Web Services.

En un reciente artículo de un blog, Munro también describió cómo analizó servicios informáticos en la nube de Google y Amazon que ayudan a otros negocios a agregar habilidades de lenguaje a aplicaciones nuevas.

Los investigadores llevan mucho tiempo advirtiendo prejuicios en la IA que aprende de grandes cantidades de datos, como los sistemas de reconocimiento facial usados por dependencias gubernamentales, así como servicios de colosos tecnológicos como Google y Facebook.

En 2015, por ejemplo, la app Google Apps fue sorprendida etiquetando a afroestadounidenses como “gorilas”.

BERT es mucho más complejo. Analizó miles de libros de publicación independiente junto con miles de artículos de Wikipedia. Aprendió a identificar la palabra faltante en una oración. BERT llega a entender en términos generales cómo la gente une palabras. Luego puede aprender otras tareas al analizar más datos.

Como resultado, eso permite a aplicaciones de IA mejorar a un ritmo que antes no era posible.

Antes, si tecleaba “¿acaso las cosmetólogas ven mucha lata trabajando?” en una búsqueda de Google, no entendía del todo qué le estaba preguntando. Pero ahora, gracias a BERT, Google responde correctamente la misma pregunta con un vínculo que describe las demandas de la vida en la industria del cuidado de la piel.

En Primer, una startup en San Francisco que se especializa en tecnologías de lenguaje natural, los ingenieros usaron recientemente a BERT para desarrollar un sistema que permite a los negocios juzgar automáticamente el sentimiento de titulares, tuits y otras transmisiones de medios online.

Los negocios usan esas herramientas para guiar operaciones bursátiles y otras decisiones pertinentes.

No obstante, John Bohannon, director de ciencia en Primer, notó un prejuicio consistente. Si un tuit o un encabezado contenía la palabra “Trump”, la herramienta casi siempre la juzgaba como negativa, independientemente de lo positivo del sentimiento.

Fuente: Clarín